Kurumsal yapay zeka yatırımları baş döndürücü bir hızla büyüyor. Bunu zaten görmemek mümkün değil. Aynı sanallaştırma veya bulut dönüşümlerinde olduğu gibi direnen şirketler ve yöneticiler olsa dahi özellikle yapay zekanın tabandan yani kullanıcılardan gelen talebi karşısında aslında herkes bir şekilde bu konuya dahil oluyor.

Ancak Gartner’ın 19 Kasım 2025’te yayımladığı “GenAI Blind Spots That CIOs Must Urgently Address” raporu, bizi çok kritik bir gerçeğe işaret ediyor:

AI projelerinin başarısını tehdit eden asıl riskler, ilk bakışta görünmeyen ikinci ve üçüncü seviye etkiler. Ve bunların en başında Shadow AI geliyor.

Bu duruma yine aslında alışkınız, hangi konuda olursa olsun özellikle yeni nesil teknolojilerdeki yatırımlarda “etki ve risk analizi” çok doğru yapılmadan projelerin başlatıldığını görüyoruz.

CISO’lar için Shadow AI yalnızca teknik bir risk değil; özellikle veri güvenliği, regülasyon, kimlik yönetimi ve operasyonel sürdürülebilirlik açısından büyüyen bir siber güvenlik krizi.

Yine raporu incelediğimiz zaman güzel bir başlık daha görüyoruz;

Shadow AI Patlaması: Güvenliğin Kör Noktası

Gartner’ın 2025 yılında 302 siber güvenlik lideriyle yaptığı ankette:

%69 kurumda çalışanların yasaklanmış kamuya açık GenAI araçlarını kullandığı tespit edildi. Bunun aslında en çok bilinen örneği ChatGPT. Evet, özellikle cam ofislerde, yani açık ofislerdeki ekranlara baktığınız zaman mutlaka birkaç tane GPT ekranı görebiliyoruz. Bu da aslında şirketin verilerinin doğrudan paylaşılması anlamına geliyor.

Bu durumun etkileri ilk anda fark edilmeyebilir ama riskler bence çok yüksek;

Riskler:

- IP ve kurumsal veri sızıntısı

- Model dışa vurumu (model leakage) – bu konu ayrıca önemli, yani size ait olan bir formülün halka açılması gibi düşünebilirsiniz.

- Regülasyon ihlalleri

- Yetkisiz kimlik kullanımı

- Fark edilmeyen veri akışları

- Denetlenmeyen iş süreçleri

Durum eğer bu hızda giderse 2030’a kadar şirketlerin %40’ından fazlası Shadow AI kaynaklı güvenlik veya uyumluluk olayı yaşanacağı düşünülüyor.

Peki buradaki tek risk güvenlik mi? Aslında farklı sorunları da şimdiden planlamak gerekiyor.

Öncelikle bu kadar çok AI kullanımı “Technical Debt” dediğimiz AI sayesinde çok hızlı üretilmiş içeriklerin uzun vadede bakım maliyetleri ve risk olarak geri dönmesi olacaktır. Burada aklınıza ilk yazılımcılar ve onların GenAI ile ürettiği kodlar gelebilir, evet tam üstüne bastınız. Özellikle bu kodlar ileride çok canımızı yakacak, hele de güvenlik anlamında. Ancak konu ne yazık ki sadece yazılım ile sınırlı değil. Buna pek çok örnek verebiliriz;

- Otomatik üretilmiş kod,

- Otomatik hazırlanmış içerik,

- Otomatik oluşturulmuş tasarım,

- Otomatik yazılmış konfigürasyon,

- AI workflow’ları,

- Prompt tabanlı iş akışları

Bunların çıktıları hızlıdır, verimlidir ama doğru şekilde yönetilmezse bakımı, doğrulanması, güncellenmesi ve güvenli hale getirilmesi zor bir sistem yığınına dönüşebilir.

Özetle yemeği hızlı yedikten sonra soda ile bu işi çözemeyebiliriz.

2030’a kadar işletmelerin %50’si GenAI Technical Debt yüzünden AI yükseltmelerinde gecikme ve bakım maliyetlerinde patlama yaşayacak.

Shadow AI ortamında geliştirilen kod, belge ve iş akışları ise tamamen sahipsiz olduğu için bu sorun daha bile hızlı büyüyecektir.

Bir diğer sorun ise “Veri ve AI Egemenliği (Sovereignty)”

2028’e kadar hükümetlerin %65’i teknoloji ve veri egemenliği zorunlulukları getirecek.

Bu da şu demek:

- AI modellerinin nerede tutulduğu önem kazanacak

- Çalışanların izinsiz olarak dış GenAI araçlarına veri göndermesi ciddi uyumluluk riski yaratacak

- Shadow AI bu süreci tamamen kontrol dışı bırakacak

Konuya sadece teknik açıdan bakmamak gerekiyor, bu kadar kontrolsüz bir şekilde Shadow AI kullanımı aynı zamanda çalışanların becerilerinin erozyona uğramasına da neden olacaktır. Özellikle basit örnekler olacak ama ben elle yazmayı azalttığımdan beri örnek el yazım çok kötüleşti, çünkü teknoloji çağında sürekli klavye kullanıyorum, kalem kullanmıyorum. Ya da kafamdan hesaplama yaparken çok daha keskin bir matematik (ben sayısalcıyım zaten) hafızam varken bilgisayar kullanımlarından sonra bu zayıfladı. Aynı şey AI içinde geçerli. Hele bu erozyona uğrayan kritik personeller ise sorunlar daha da büyüye bilir.

Shadow AI’da bu erozyon daha da tehlikeli çünkü:

- Kullanılan araçlar görünmüyor

- Süreçler kayıt altına alınmıyor

- Sonuçlar tekrar edilemiyor

- Kritik kararlar görünmez sistemlere bağımlı hale geliyor

Gelelim son soruna. Örneğin Microsoft copilot kullanacaksınız, altına, üstüne bakarsınız, içini açar kurcalarsınız ve sonra bağımlılıklarını çıkarıp kullanmaya başlarsınız. Yani hangi sistemlere bağımlı hale geldiğinizi bildiğiniz için kontrollü bir “Vendor Lock-in” içerisinde olursunuz. Ancak Shadow AI bu kontrolü de elinizden alacağı için kontrolsüz bir bağımlılığa dönüşen bir sistemi yönetmek zorunda kalabilirsiniz.

Peki çözüm önerisi nedir?

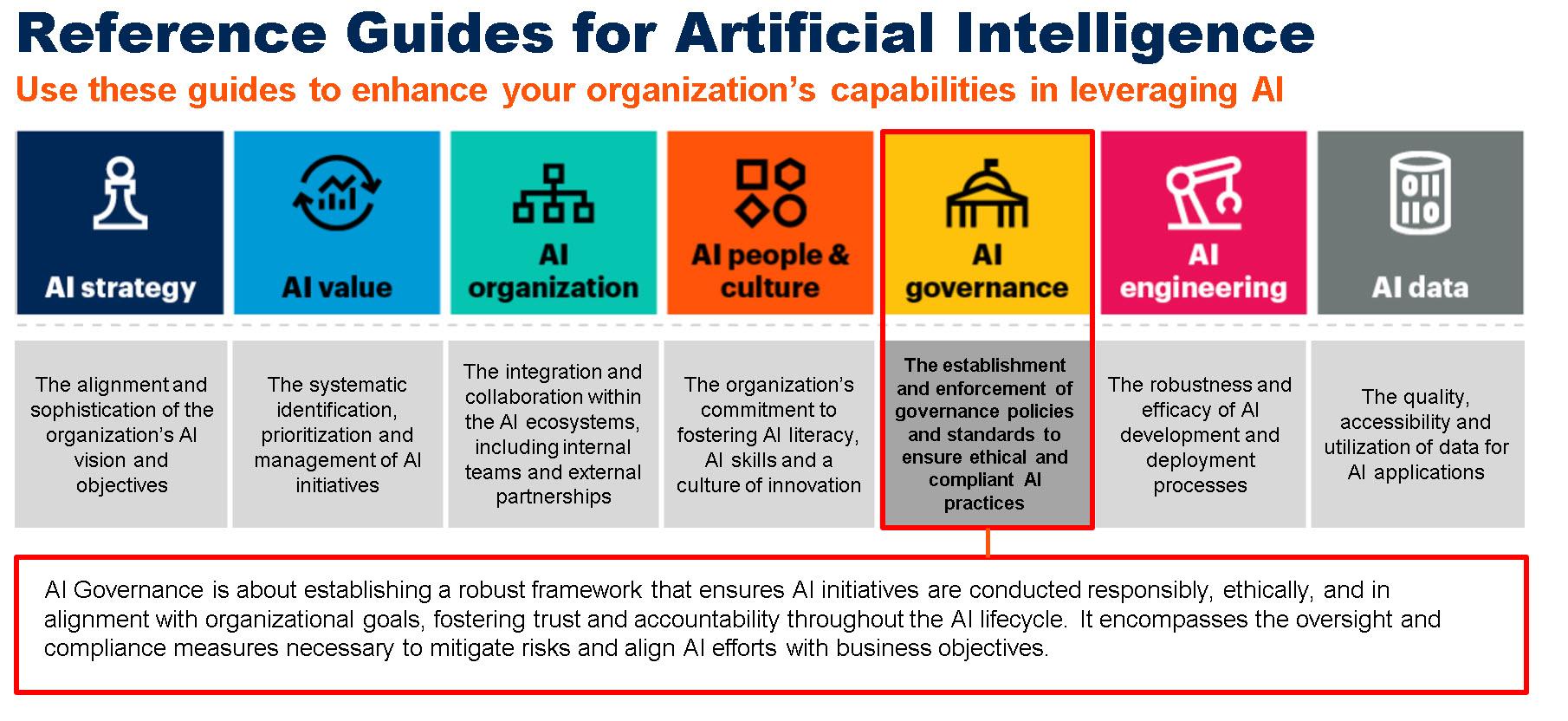

Benim önerim AI governance olacaktır. Burada ilk iş tabi ki bir AI programı oluşturmak ile başlıyoruz ancak ikinci adım Shadow AI tespiti. Yani Shadow AI o kadar önemli ki AI ile ilgili bir anayasa yazdığınızı düşünün, ikinci maddesi Shadow AI…

Temel başlıklar ise aşağıdaki gibidir;

- Kurumsal AI Politikası ve Risk Yönetişimi Geliştirin

- AI kullanımının ne zaman, nasıl ve hangi araçlarla yapılabileceği tanımlanmalı

- AI içeriği yönetimi ve versiyonlama kurulmalı

- SaaS değerlendirmelerine “GenAI risk değerlendirmesi” hazırlanmalı

- Shadow AI Tespit Mekanizmaları Oluşturun

- DLP, CASB, proxy ve ağ izleme araçlarıyla AI trafiğini görünür kılın

- Kimlik yönetiminde non-human identity stratejisini uygulayın

- AI kullanım loglarını toplayan bir SOC süreci kurun

- İnsan Uzmanlığını Korumak İçin Hibrit Yapı Kurgulayın

- Hangi iş adımlarında insan kararının zorunlu olduğu belirlenmeli

- AI çıktıları için kalite kontrol ve “human-in-the-loop” süreçleri uygulanmalı

- Uzmanlık kaybına karşı bilgi birikimi odaklı eğitim programları hazırlanmalı

- Açık Standartlar ve Modüler Mimariler Kullanın

Vendor lock-in’e karşı:

- Açık API’lar

- Açık modeller

- Modüler GenAI katmanları

- Çoklu vendor stratejileri

Kullanın

Özetle Shadow AI, görmezden gelindikçe büyüyen bir tehdit olduğu için mutlaka gündeminizde tutmanız gerekiyor.